n8n Ersteinrichtung & Dein erster lokaler AI-Chatbot

Du hast n8n erfolgreich installiert? Super! Jetzt machen wir uns an die Feinarbeit. In diesem Tutorial führen wir dich durch die komplette initiale Einrichtung – vom ersten Login bis hin zu deinem ersten funktionierenden AI-Chatbot mit Ollama.

Wir gehen alle Schritte gemeinsam durch, basierend auf unserer Dokumentation.

Teil 1: Die Grundeinrichtung

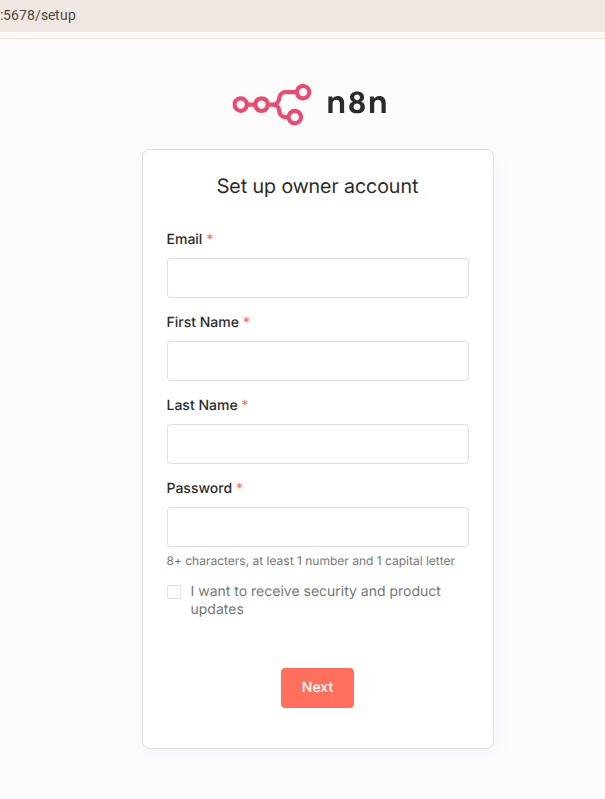

1. Den Owner-Account erstellen

Sobald du deine n8n-Instanz zum ersten Mal im Browser aufrufst, begrüßt dich der Setup-Screen. Hier legst du den Administrator (Owner) fest. Das ist wichtig, damit niemand sonst Zugriff auf deine Workflows hat.

Fülle die Felder für E-Mail, Name und ein sicheres Passwort aus.

Tipp: Achte auf ein starkes Passwort, da n8n später Zugriff auf viele deiner Dienste haben wird.

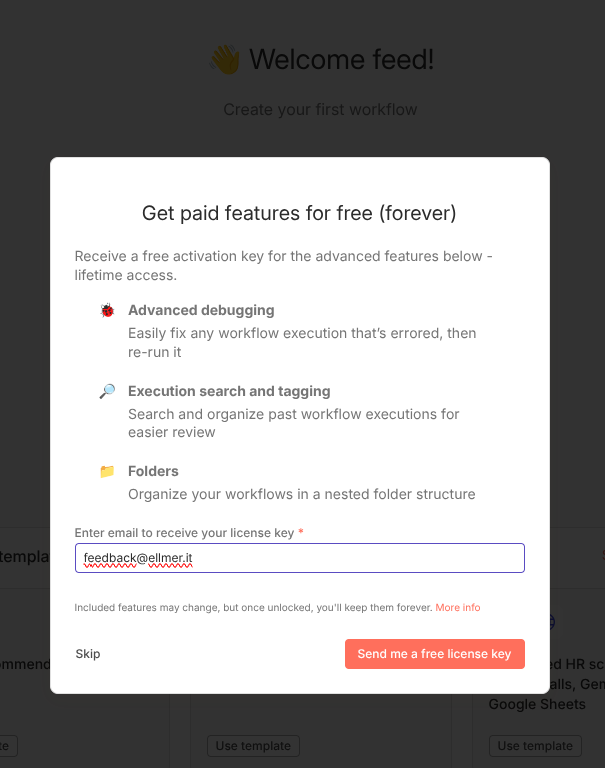

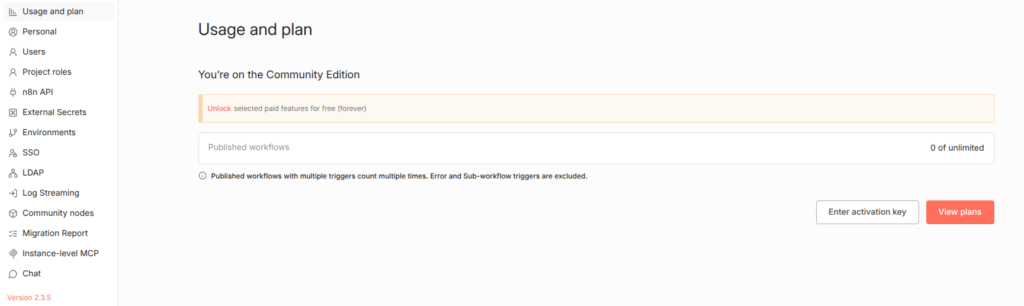

2. Features freischalten (Lizenzierung)

Nach dem Erstellen des Kontos bietet dir n8n an, erweiterte Features kostenlos freizuschalten („Get paid features for free“). Dazu gehört z.B. das Debugging oder granulare Nutzerrechte.

Gib hier deine E-Mail-Adresse ein, um den Aktivierungsschlüssel zu erhalten.

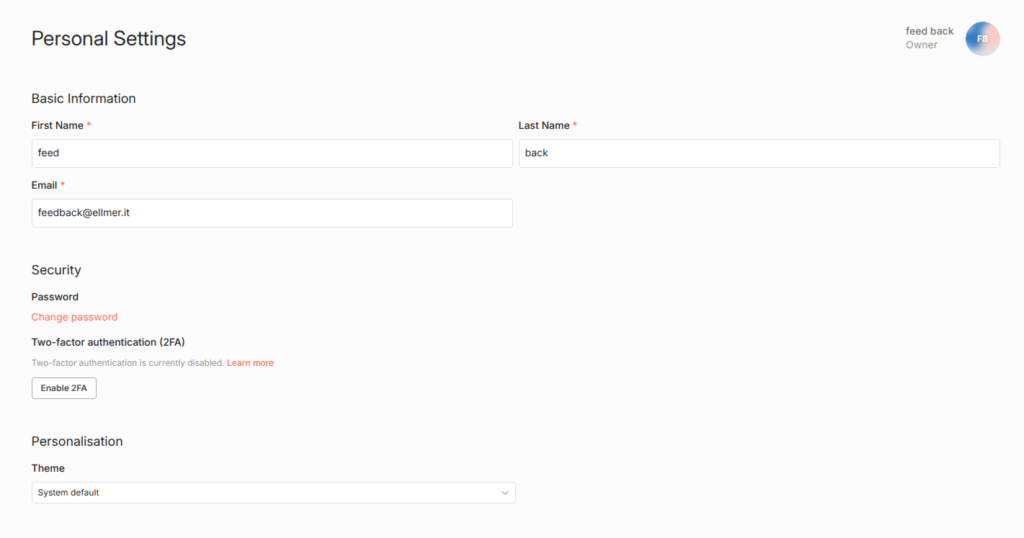

3. Sicherheit erhöhen: MFA aktivieren

Sicherheit geht vor. Navigiere in deine Personal Settings (persönliche Einstellungen). Hier solltest du nicht nur deine Daten überprüfen, sondern auch die Zwei-Faktor-Authentifizierung (2FA) aktivieren.

Teil 2: Vorbereitung für AI & LLMs

n8n ist mittlerweile extrem mächtig im Bereich KI. Damit wir das nutzen können, müssen wir die entsprechenden Provider aktivieren.

4. MCP und Chat-Provider aktivieren

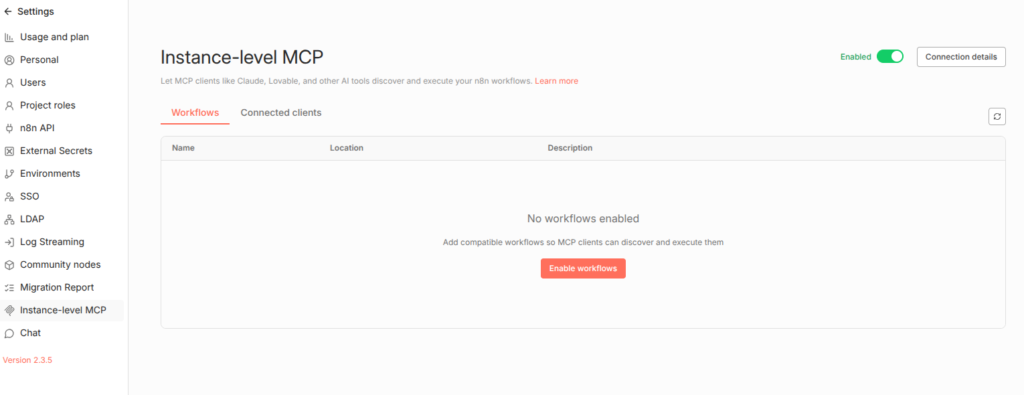

Gehe in die Systemeinstellungen (Settings).

- Wähle links Instance-level MCP und stelle sicher, dass der Schalter auf „Enabled“ steht.

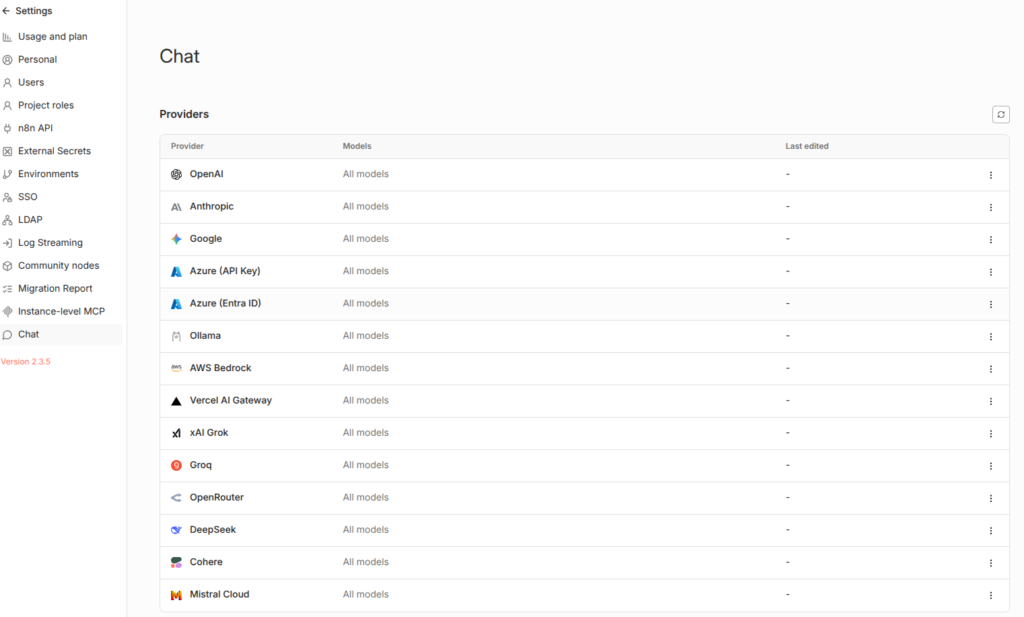

- Wechsle zum Menüpunkt Chat. Hier siehst du eine Liste aller verfügbaren AI-Provider wie OpenAI, Anthropic oder – für uns wichtig – Ollama.

5. Ollama verbinden (Lokale AI)

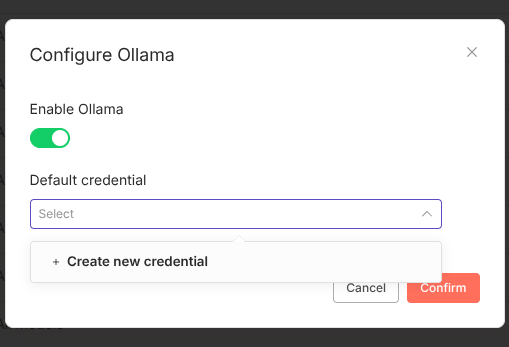

Wir wollen ein lokales Modell nutzen. Klicke auf „Configure“ bei Ollama und aktiviere den Schalter „Enable Ollama“.

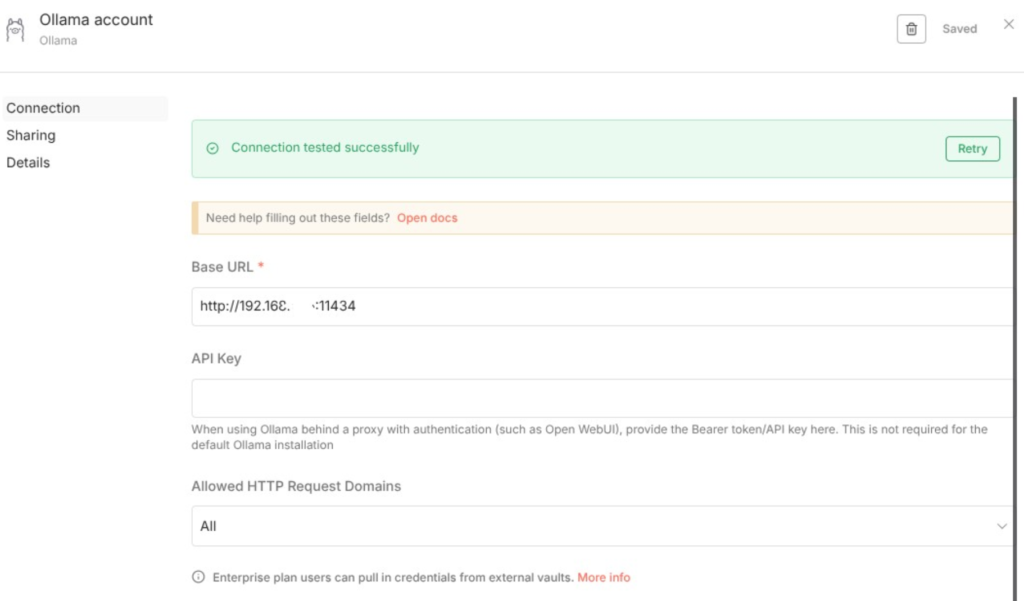

Danach musst du die Verbindung herstellen (Credentials). Erstelle neue Credentials und gib die Base URL deines Ollama-Servers an.

- In unserem Beispiel läuft Ollama auf einem anderen Gerät im Netzwerk:

http://192.168.x.x:11434 - Wenn es auf dem gleichen Rechner läuft, ist es meist

http://localhost:11434.

Teil 3: Dein erster Workflow

Jetzt wird es spannend. Wir bauen einen Chatbot!

6. Workflow anlegen

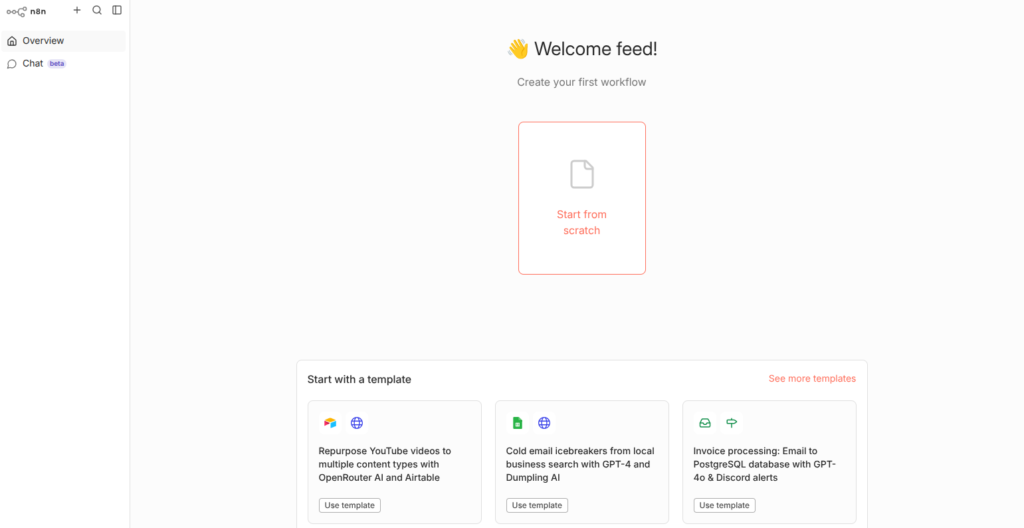

Du landest auf dem leeren Dashboard. Klicke auf „Create your first workflow“ oder „Start from scratch“.

7. Der Trigger: „On chat message“

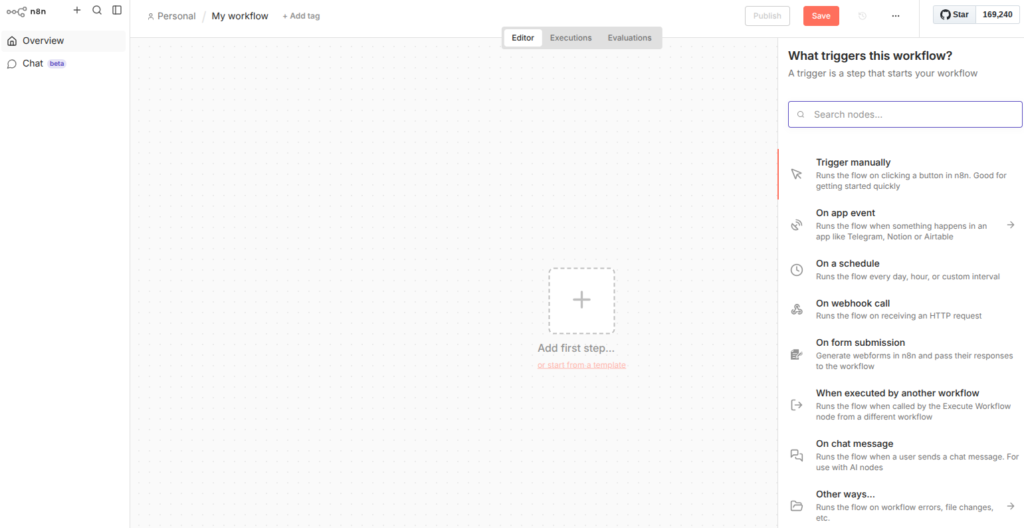

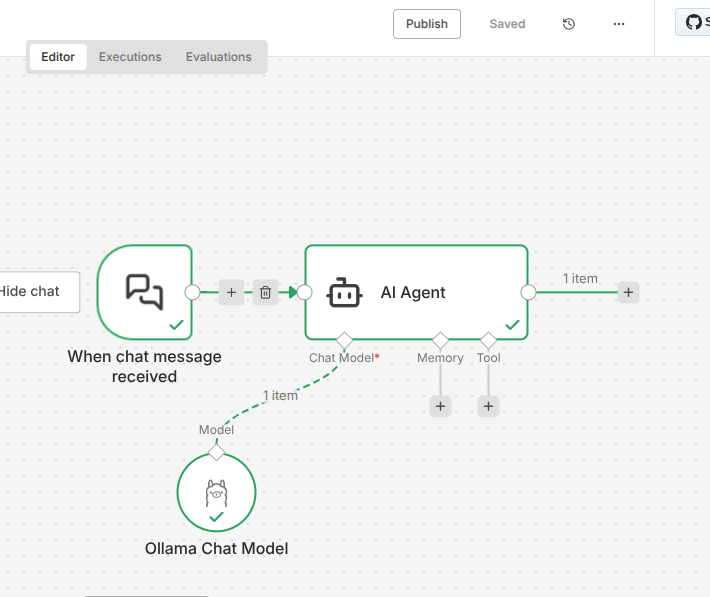

Jeder Workflow braucht einen Auslöser. Suche im Trigger-Menü nach „On chat message“. Das bedeutet, der Workflow startet, sobald jemand im Chat-Fenster eine Nachricht tippt.

8. Die AI-Logik hinzufügen

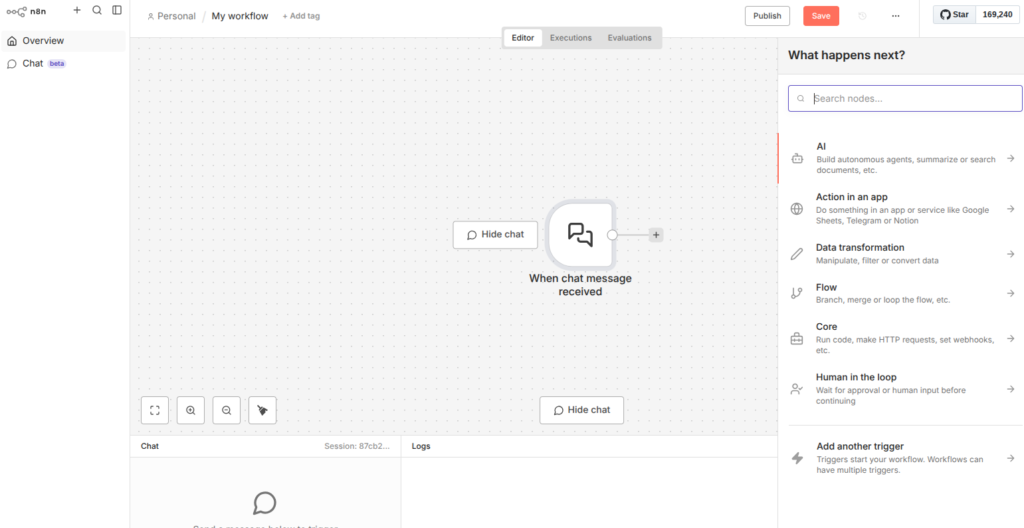

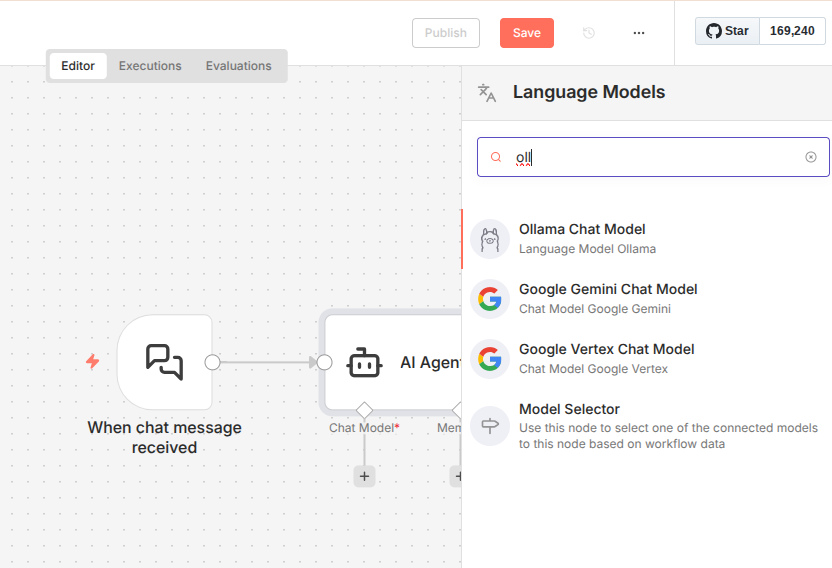

Klicke auf das Plus-Zeichen hinter deinem Chat-Trigger. Wähle im Menü „What happens next?“ die Kategorie AI aus.

Wähle anschließend den AI Agent Node. Dieser ist das „Gehirn“, das die Anfrage verarbeitet.

9. Das Modell verknüpfen

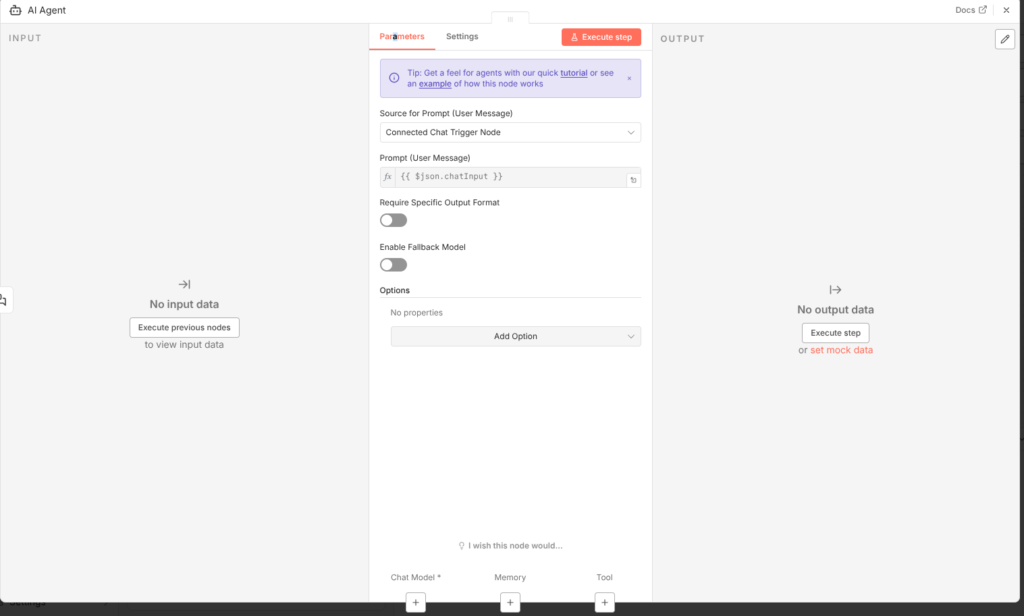

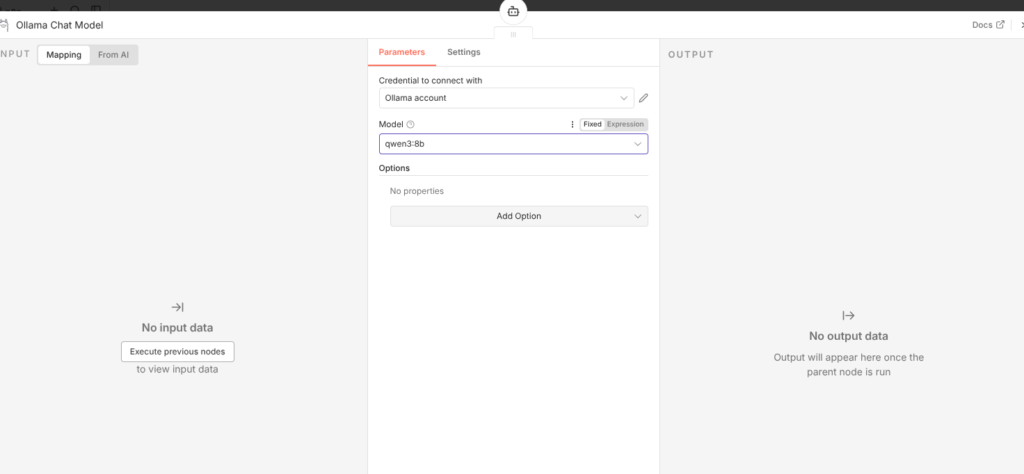

Der AI Agent braucht ein Sprachmodell. Klicke unten am Agent-Node auf den Anschluss für „Model“ und wähle Ollama Chat Model.

In den Einstellungen des Ollama-Models wählst du:

- Deine eben erstellten Credentials (Ollama account).

- Das gewünschte Modell aus der Liste (in unserem Beispiel nutzen wir

qwen3:8b, ein sehr leistungsfähiges Modell).

Teil 4: Testen & Go Live

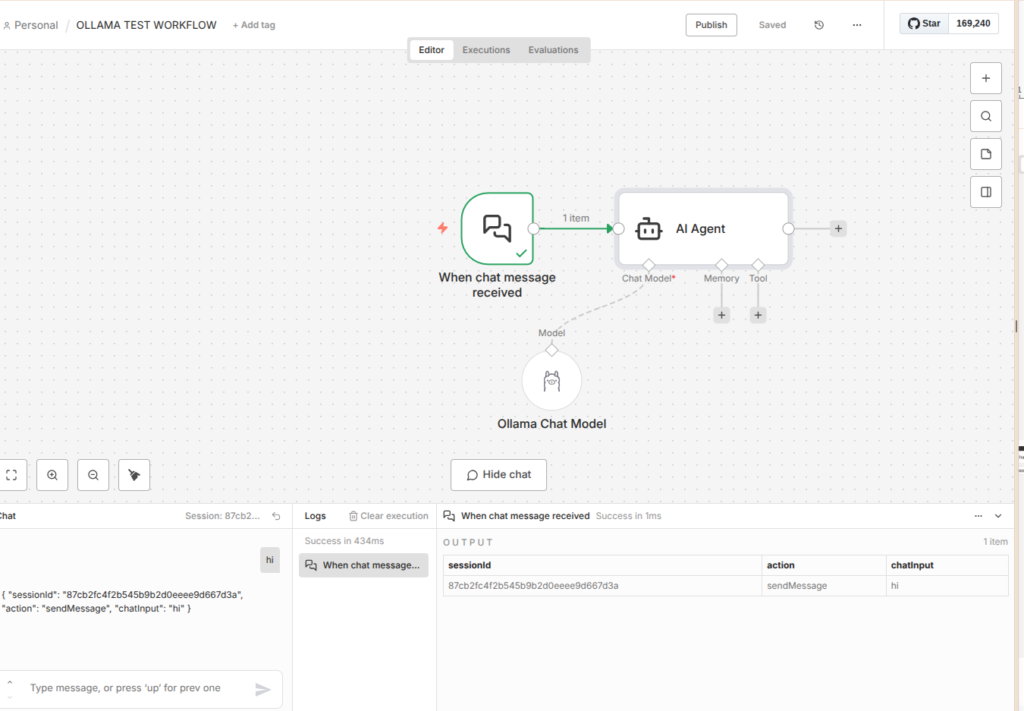

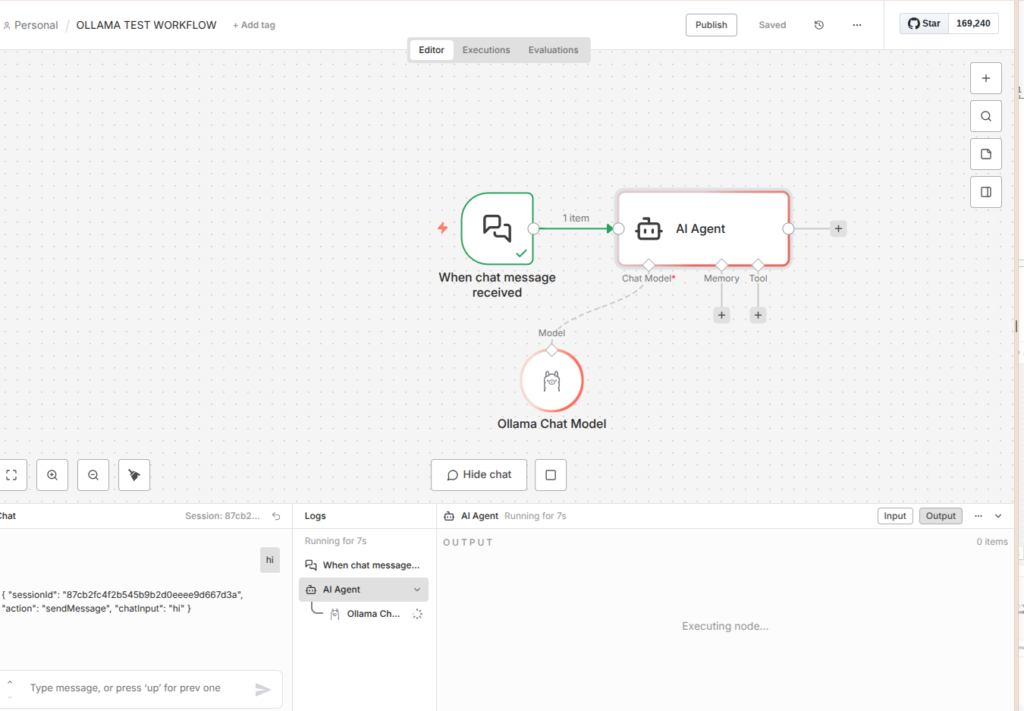

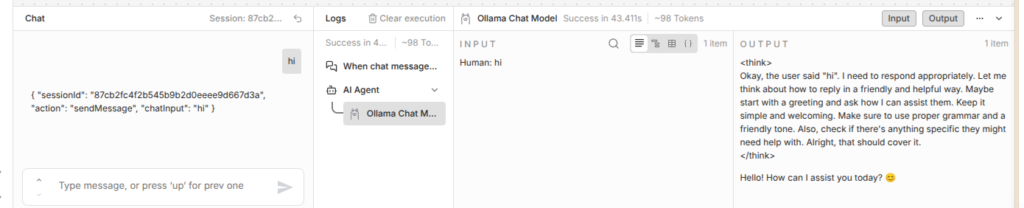

10. Den Chat testen

Klicke unten auf den Button „Chat“, um das Testfenster zu öffnen. Tippe „hi“ ein und sende die Nachricht ab.

Du wirst sehen, wie der Workflow arbeitet. Im Hintergrund „denkt“ das Modell (<think>...) und gibt dir dann eine freundliche Antwort aus: „Hello! How can I assist you today?“.

11. Veröffentlichen

Funktioniert alles? Perfekt! Vergiss nicht, oben rechts auf Activate (Schalter umlegen) und Save zu klicken, damit dein Bot dauerhaft erreichbar ist.

Fazit

Happy automation! Du hast in wenigen Minuten eine komplette n8n-Instanz aufgesetzt und deinen ersten eigenen AI-Bot mit lokalem LLM gebaut.

EASY ODER?